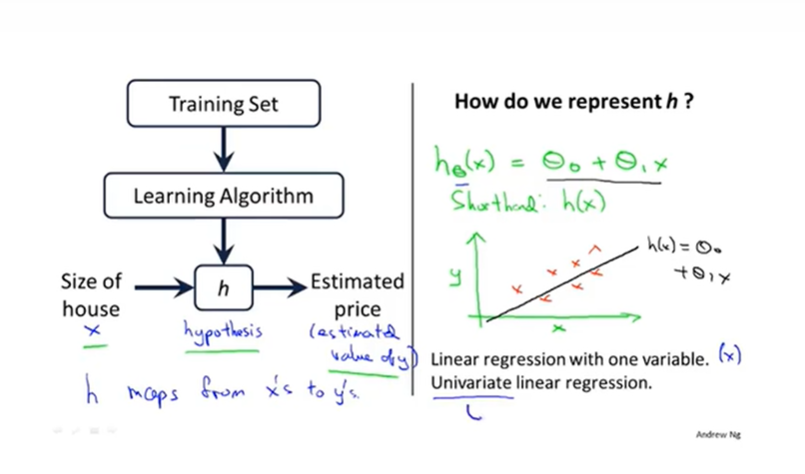

2-1模型描述

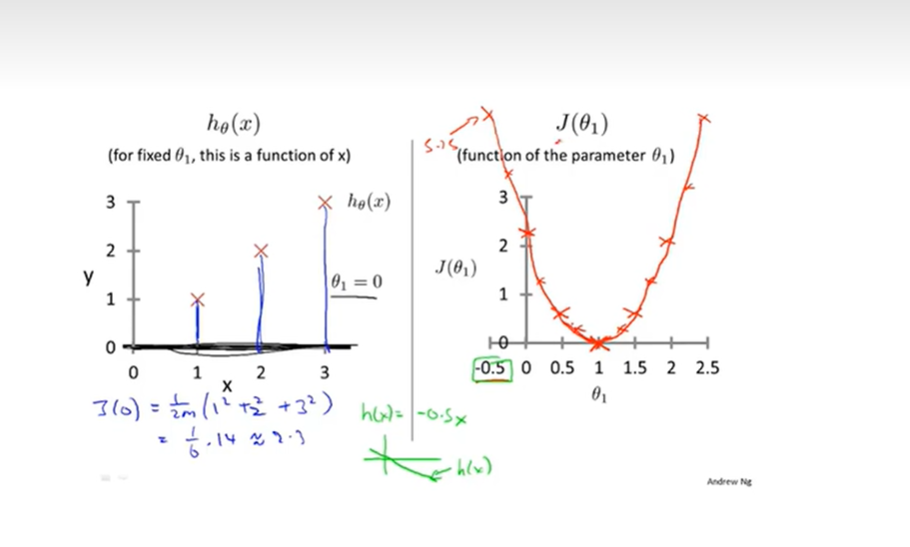

2-2代价函数

最小化方差。代价函数=$min\sum_{i=1}^{n}(h_\theta (x^i)-y^i)$

2-3,2-4代价函数

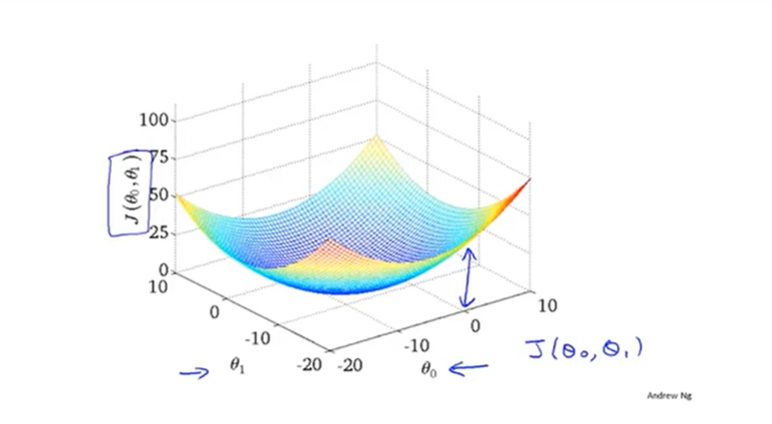

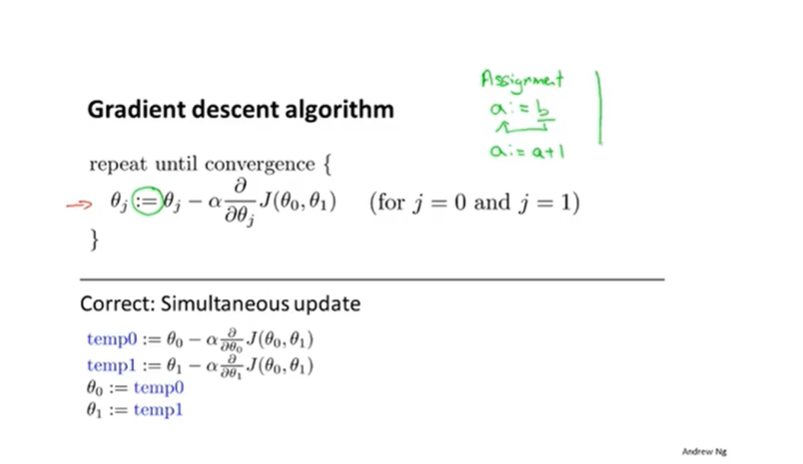

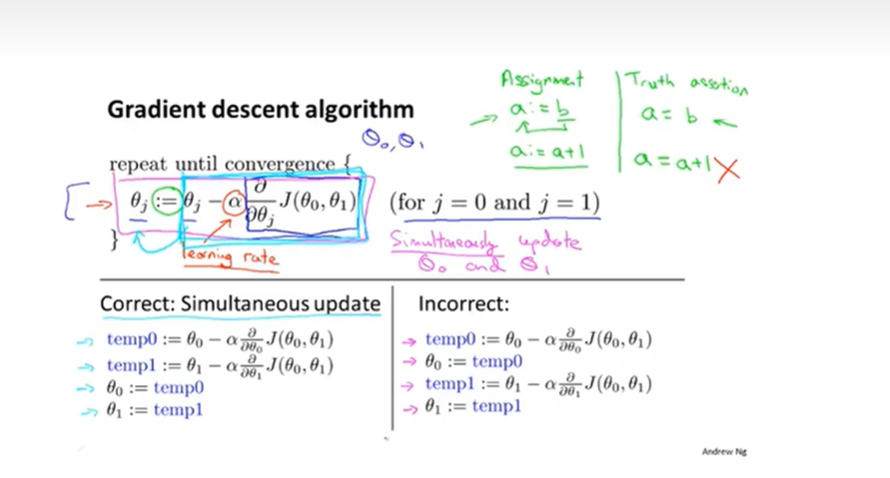

2-5梯度下降

常规算法,不仅用在线性回归,还用在很多机器学习中

梯度下降过程中计算的$\theta_i$可能和实际图中的$\theta_i$有偏差,这个影响不大。下一次再计算用的依旧是实际图中的值 $J(\theta_{0_{i-1}}, \theta_{1_{i-1}})$

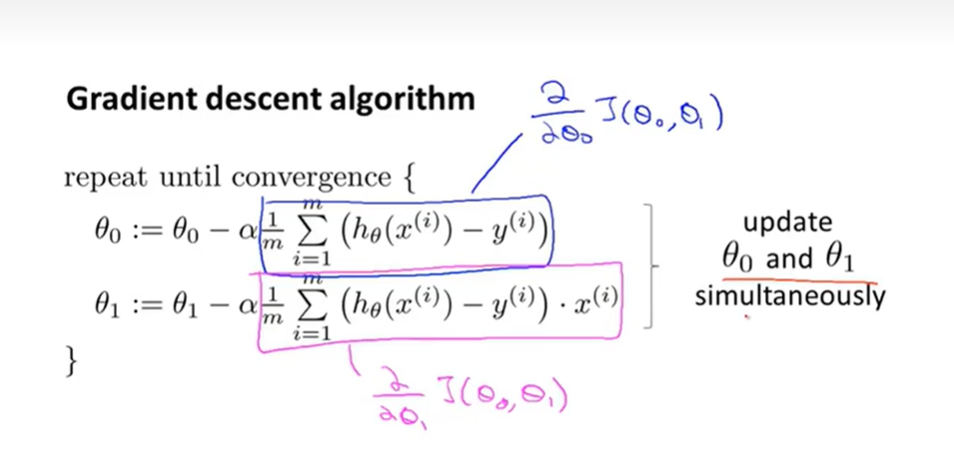

2-6,2-7

以上讲的都是batch梯度下降法:每一次计算遍历所有数据集。